Facebook宣布神經超采樣實時渲染,實現VR高清顯示新突破,低清圖像實時轉高清

VR實時渲染提出了一系列獨特的挑戰,其中最主要的是支持圖片級真實感效果,實現更高的分辨率,并達到比以往任何時候都更高的刷新率。為了應對這一問題,Facebook Reality Labs(FRL)的研究人員開發了DeepFocus。這個于2018年12月首次亮相的渲染系統主要是利用人工智能在變焦頭顯中創建超逼真的視覺效果。團隊將在今年的SIGGRAPH大會介紹研究的下一篇章,并表示它將開啟為虛擬現實創造未來高保真顯示器的全新里程碑。

將在SIGGRAPH大會介紹的論文名為“Neural Supersampling for Real-time Rendering(用于實時渲染的神經超采樣)”介紹了一種可以將低分辨率輸入圖像轉換為高分辨率輸出的機器學習方法。這種upsampling(上采樣)過程利用了神經網絡并以場景統計進行訓練,從而能夠恢復清晰的細節,同時節省在實時應用程序中直接渲染所述細節的計算開銷。

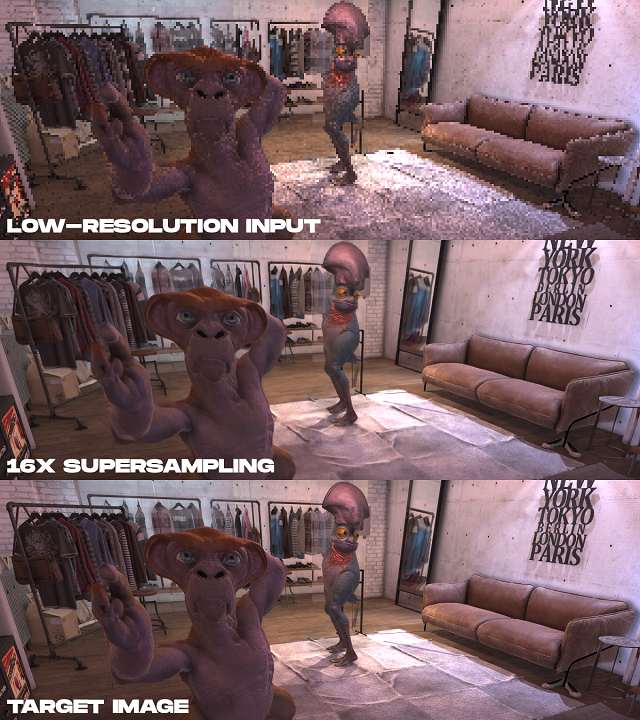

上面的GIF動圖比較了低分辨率顏色輸出和神經超采樣方法實現的16x超采樣輸出。

1. 研究的是什么?

為了降低高分辨率顯示器的渲染成本,FRL使用的輸入圖像的像素比期望輸出少16倍。例如,如果目標顯示器的分辨率為3840×2160,FRL的神經網絡將以游戲引擎渲染的960×540分辨率輸入圖像著手,并作為一種實時后處理過程將其upsample(上采樣)至目標顯示分辨率。

盡管社區已經存在大量關于攝影圖像的機器學習upsampling(上采樣)研究,但沒有一個直接談及渲染內容(如游戲引擎生成的圖像)的獨特需求。這是由于渲染圖像和攝影圖像在圖像形成方面的根本區別。在實時渲染中,每個采樣點在空間和時間上都是一個點。所以渲染內容通常是高度鋸齒,會產生鋸齒狀的線條和其他采樣偽影。對于這一點,你可以參閱本文的低分辨率輸入示例。這使得渲染內容的upsampling上采樣既是一個抗鋸齒問題,同時又是一個內插問題,不同于已得到計算機視覺領域充分研究的去噪和去模糊問題。對于輸入圖像高度鋸齒,以及需要插值的像素完全丟失信息這一事實,這為渲染內容生成高保真和時間相干重建提出了重大挑戰。

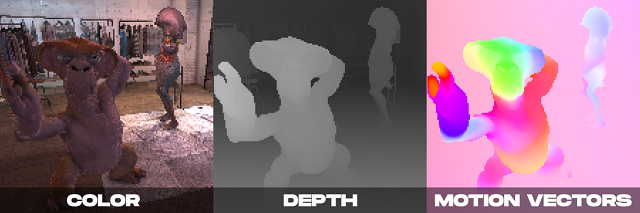

用作神經超采樣方法輸入的示例渲染屬性以低分辨率渲染,包括顏色、深度和密集運動矢量。

另一方面,在實時渲染中,我們可以擁有的不僅只是攝像頭生成的彩色圖像。正如DeepFocus所示,現代渲染引擎中可以同時提供深度值等附加信息。FRL研究人員發現,對于神經超采樣,由運動矢量提供的附加輔助信息特別有效。運動矢量定義了序列幀中像素之間的幾何對應關系。換言之,每個運動矢量指向一個亞像素位置,其中在一幀中可見的曲面點可能已經出現在上一幀中。所述值通常是利用計算機視覺方法進行估計,但這種光流估計算法容易出錯。相比之下,渲染引擎可以直接生成密集運動矢量,從而為應用于渲染內容的神經超采樣提供可靠的、豐富的輸入。

FRL的方法是以上述觀察作為基礎,同時結合額外的附加信息,以及一個旨在最大限度提高圖像和視頻質量并提供實時性能的全新時空神經網絡設計。

在推理時,神經網絡以低分辨率渲染當前幀和多個先前幀的渲染屬性作為輸入,如每幀的顏色、深度貼圖和密集運動矢量。網絡的輸出是與當前幀相對應的高分辨率彩色圖像。網絡采用監督學習的方法進行訓練。在訓練時,提供采用抗鋸齒函數并以高分辨率渲染,同時與每個低分辨率輸入幀配對的參考圖像,將其作為訓練優化的目標圖像。

示例結果:從上到下是低分辨率顏色輸入;所介紹方法的16x超采樣結果;以及離線渲染的目標高分辨率圖像。

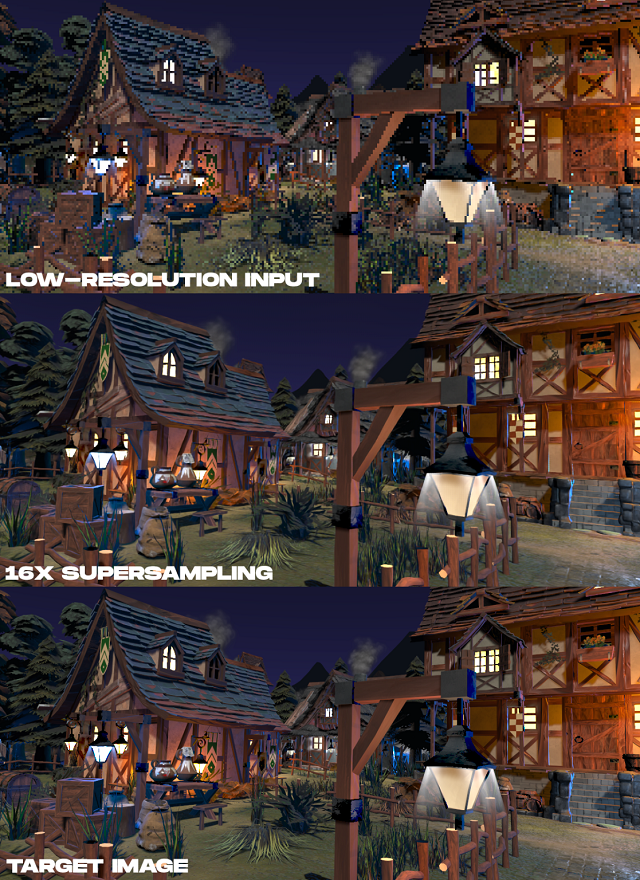

示例結果:從上到下是低分辨率顏色輸入;所介紹方法的16x超采樣結果;以及離線渲染的目標高分辨率圖像。

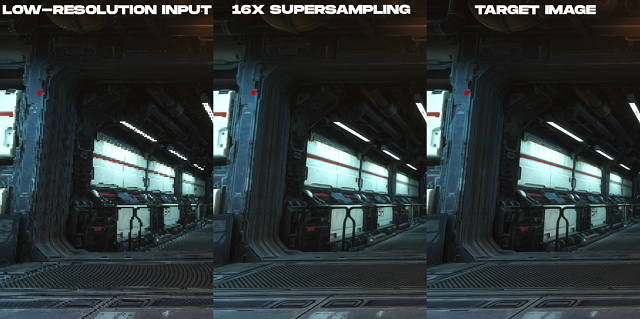

示例結果:從左到右是低分辨率顏色輸入;所介紹方法的16x超采樣結果;以及離線渲染的目標高分辨率圖像。

2. 下一步計劃

FRL團隊表示:“神經渲染在AR/VR中有著巨大的潛力。盡管這一問題具有挑戰性,但我們希望鼓勵更多的研究人員在這方面開展研究。隨著AR/VR顯示器向著更高分辨率、更快幀速率和更高真實感的方向發展,神經超采樣方法可能是從場景數據中推斷出清晰細節而非直接渲染的關鍵。這項研究為未來的高分辨率VR指明了方向,不僅僅是關于顯示器,同時包括實際驅動所需的算法。”

原文來自映維網:https://yivian.com/news/76087.html

讓VR全景給新聞行業帶來不一樣

讓VR全景給新聞行業帶來不一樣  谷歌用46個攝像頭組“復眼”,打造沉浸式AR/VR光場視頻方案

谷歌用46個攝像頭組“復眼”,打造沉浸式AR/VR光場視頻方案